Elon Musk开源Grok

早在6天前,马斯克就发文称@xAI将开源Grok

13小时前,马斯克开源了旗下公司X的Grok训练模型,并喊话OpenAI,你名字里的Open到底在哪里

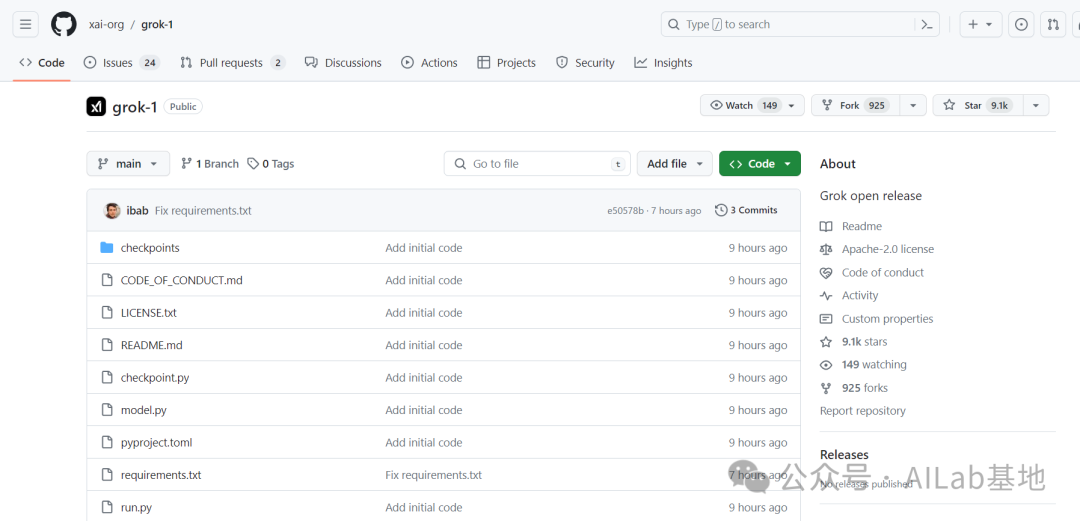

下面是@xai-org的GitHub开源地址[https://github.com/xai-org/grok-1]

值得一说的是,克隆下来之后并不能直接跑,还有300多个G的权重文件需要下载。模型拥有 3140 亿个参数,属于混合专家模型(MoE: Mixture-of-Experts model)。模型特点是在处理每个token时,只有25%的权重(weights)被激活。它是在2023年10月,利用JAX和Rust构建的自定义训练栈,从头开始训练的。

这是开源主页README给出的提示:

原文:Due to the large size of the model (314B parameters), a machine with enough GPU memory is required to test the model with the example code. The implementation of the MoE layer in this repository is not efficient. The implementation was chosen to avoid the need for custom kernels to validate the correctness of the model.

译文:由于模型规模较大(314B参数),需要有足够GPU内存的机器才能使用示例代码测试模型。该存储库中 MoE 层的实现效率不高。选择该实现方式是为了避免需要自定义内核来验证模型的正确性。

来源:[https://x.ai/blog]