轻量化分割 | P2AT提出金字塔池化Axial Transformer方法,让基于ViT的语义分割飞快

共 10395字,需浏览 21分钟

· 2023-10-30

点击下方卡片,关注「集智书童」公众号

最近,基于Transformer的模型在各种视觉任务中取得了令人鼓舞的成果,这是因为它们能够建模长距离的依赖关系。然而,Transformers的计算成本很高,这限制了它们在自动驾驶等实时任务中的应用。此外,对于准确的密集预测,特别是驾驶场景理解任务,高效的局部和全局特征选择和融合至关重要。

在本文中,作者提出了一种名为金字塔池化Axial Transformer(P2AT)的实时语义分割架构。所提出的P2AT从CNN编码器中获取粗糙特征,以生成具有尺度感知性的上下文特征,然后将其与多级特征聚合方案相结合,以生成增强的上下文特征。

具体来说,作者引入了金字塔池化Axial Transformer来捕获复杂的空间和通道依赖关系,从而提高了语义分割的性能。然后,作者设计了一个双向融合模块(BiF)来融合不同级别的语义信息。与此同时,引入了全局上下文增强模块来弥补不同语义级别连接的不足。最后,作者提出了一个解码器块,以帮助维护更大的感知域。

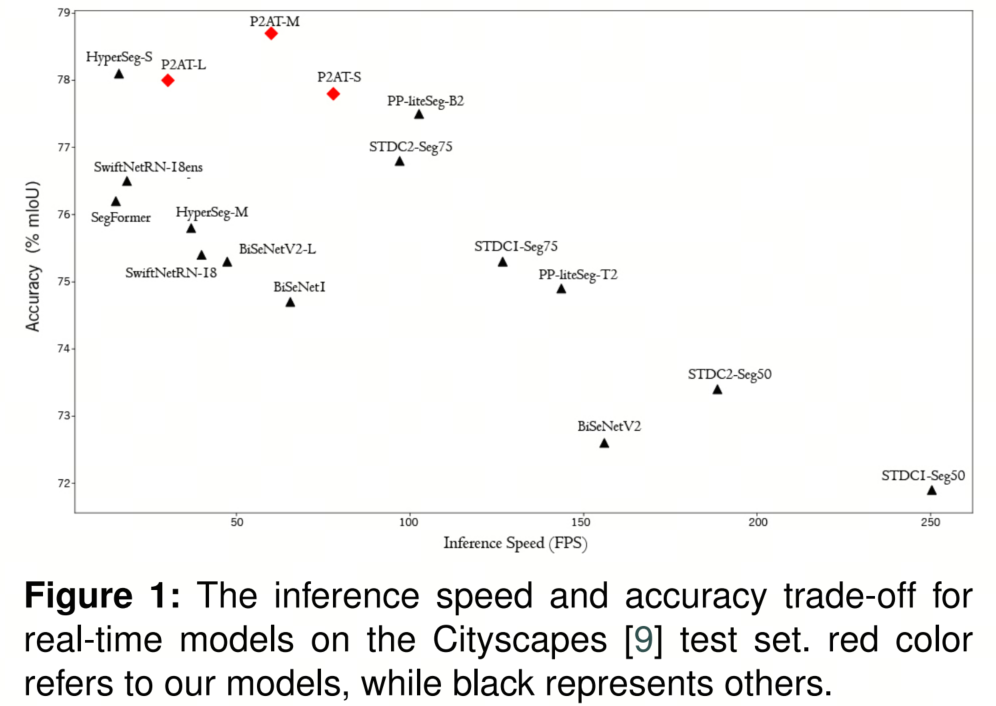

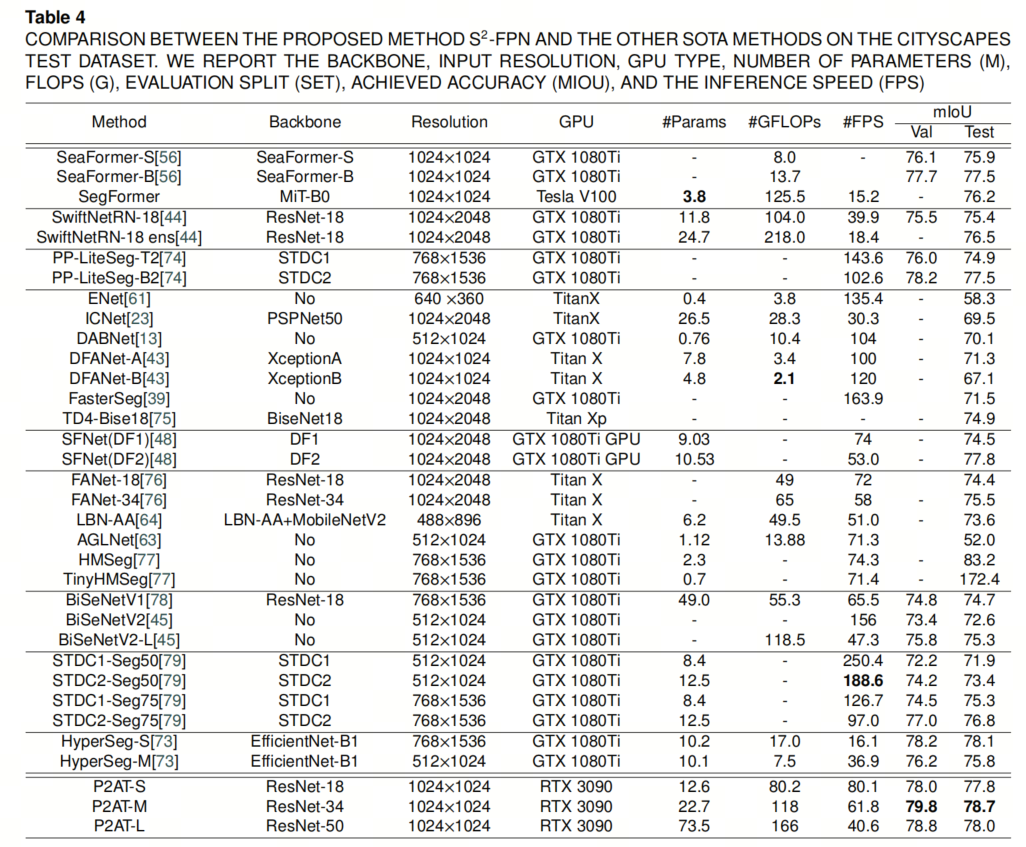

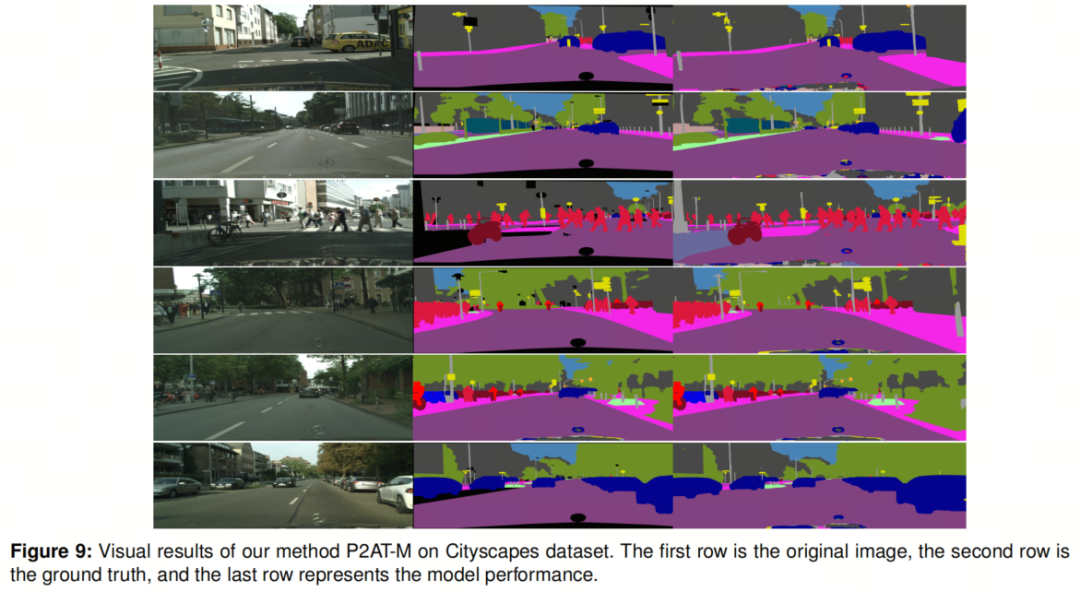

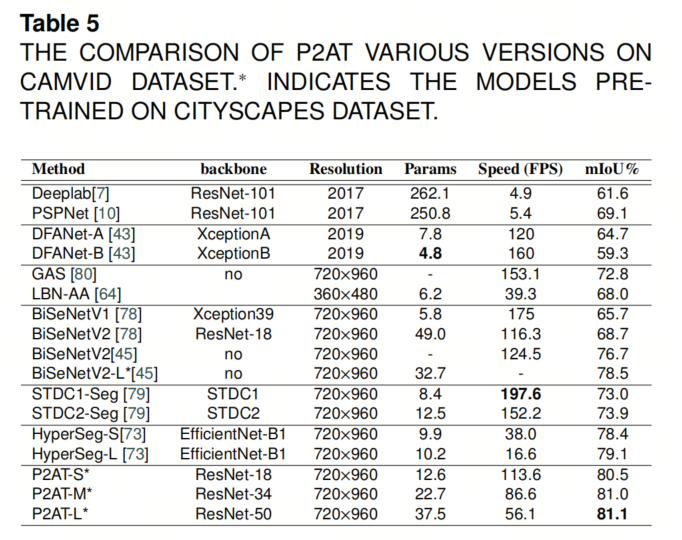

作者在三个具有挑战性的场景理解数据集上评估了P2AT变种。特别是,作者的P2AT变种在Camvid数据集上实现了最先进的结果,P2AT-S、P2AT-M和P2AT-L分别达到了80.5%、81.0%和81.1%。

此外,作者在Cityscapes和Pascal VOC 2012上的实验显示了所提出架构的高效性,结果表明P2AT-M在Cityscapes上达到了78.7%。

1. 简介

感知是任何智能驾驶系统的重要任务,它收集了移动车辆周围环境的必要信息。作为自动驾驶不可分割的一部分,视觉感知正在被主要的主流汽车制造商、企业、大学和科研机构进行探索和研究。人工智能在汽车工业的大规模应用加速了该领域的发展。高精度和高速的架构对于先进驾驶辅助系统和自动驾驶汽车未来的发展至关重要。

基于深度学习的视觉感知算法的研究是工业技术应用的重要组成部分,因为深度学习方法在许多研究方向,如交通标志识别、车道检测、目标检测、驾驶自由空间识别和语义分割等方向,构建强大的智能驾驶算法具有独特的能力。快速准确的语义分割和目标检测是安全智能驾驶的先决条件。

随着图像内容复杂性的增加,语义分割任务由于复杂的结构和颜色、纹理和尺度的变化而变得越来越具有挑战性。近年来,深度学习对各种语义分割方法的发展产生了显著影响,成为主导框架。许多用于语义分割的最先进方法使用全卷积网络(FCNs)作为基本组件。

值得注意的是,PSPNet 和Deeplab引入了用于捕获多尺度上下文信息的专门模块,即金字塔池化模块(PPM)和孔径空间金字塔模块(ASPP)。尽管取得了这些进展,但挑战仍然存在,特别是在处理复杂的图像内容时,因为现有方法倾向于生成不精确的掩码。

近年来,Vision Transformer(ViT)在图像分类方面的显著性能已经激发了将其应用于语义分割任务的努力。与以前的语义分割卷积神经网络(CNNs)相比,这些努力取得了显著的改进。然而,对于语义分割的纯Transformer模型的实施在处理大输入图像时具有相当大的计算成本。

为解决这个问题,Hierarchical Vision Transformers引入了一种更具计算效率的替代方法。SegFormer提出了编码器和解码器的改进设计,从而实现了高效的语义分割ViT。然而,SegFormer依赖于增加编码器模型容量来提高性能,这可能限制了整体效率。

与前面提到的引入了纯Transformer进行密集像素预测的方法不同,作者提出了一种混合架构,用于更好、更高效地进行自动驾驶的语义分割。具体来说,由于上下文信息对于语义分割至关重要,作者在CNN中使用金字塔池化Axial Transformer来有效地捕获全局上下文信息。

为了充分利用Transformer和CNN的优点,作者提出了一个双向融合模块,用于集成来自网络编码器的特征和全局上下文信息,然后使用全局上下文增强器对其进行改进。作为混合ConvNet-Transformer框架,作者的P2AT可以以更快的推断速度准确地分割自动驾驶场景中的对象。

作者的主要贡献总结如下:

-

为实时语义分割引入了一种新颖的金字塔池化Axial Transformer框架(P2AT)。为了在精度和速度之间实现权衡,设计了4个模块,包括尺度感知上下文聚合模块、多级特征融合模块、解码器和特征改进模块,从而实现了以下贡献。

-

将金字塔池化引入到Axial Transformer中,以提取上下文特征,从而更容易在小数据集中训练。

-

引入了多级融合模块,用于融合编码的详细表示和深层语义特征。具体来说,设计了基于语义特征上采样器(SFU)和局部特征改进(LFR)的双向融合(BiF)模块,以获得高效的特征融合。

-

引入了全局上下文增强(GCE)模块,以弥补连接不同语义级别的不足。

-

提出了一种基于增强ConvNext的高效解码器和特征改进模块,以去除噪音,增强最终预测。

-

在三个具有挑战性的场景理解数据集上评估 P2AT:Camvid、Cityscapes 和 PASCAL VOC 2012。结果表明 P2AT 取得了最先进的结果。

2. 方法

2.1. P2AT 的整体架构

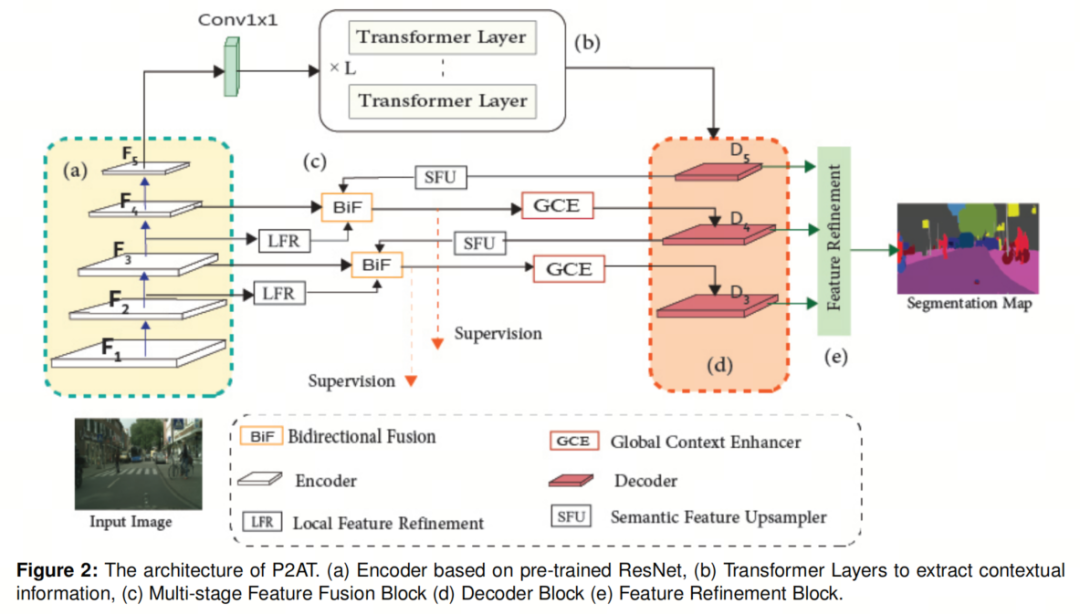

图2展示了提出的 P2AT 的结构图。首先,作者概述了用于实时语义图像分割的 P2AT 的结构。然后,作者详细分析了构建模型的若干关键要素的重要性,包括:

-

基于预训练 ResNet 的编码器

-

金字塔池化Axial 注意力,这是该方法的主要构建模块

-

用于高效融合不同阶段特征的双向融合模块

-

解码器块

给定输入图像 ,其中 C 表示通道数,W 和 H 表示空间分辨率,作者首先使用 ResNet 生成高级特征,然后集成了提出的Transformer层,以补充CNN在建模上下文特征时的不足。然后,将这些特征馈送到解码器中,解码器的作用是保持全局上下文信息。

然后,这些高语义特征通过双向融合模块与低级特征进行融合;BiF 在组合不同语义特征时非常高效。最后,作者使用全局上下文增强模块增强输出特征,并在最终预测之前进行了细化。

2.2. 全局和局部特征的重要性

典型的编码器-解码器框架通常利用浅层来编码携带目标对象详细信息的高分辨率特征图,利用深层来编码更高级别的语义信息。然而,如双线性插值和反卷积等简单的上采样策略无法收集全局上下文信息并在降采样过程中恢复丢失的信息。在作者的工作的这一部分,作者旨在通过设计一种网络来提高语义分割性能,该网络能够克服编码器-解码器架构的一些问题。为此,作者开发了几个模块和块,并将它们组合在一起构建P2AT。

2.3. 双向融合模块

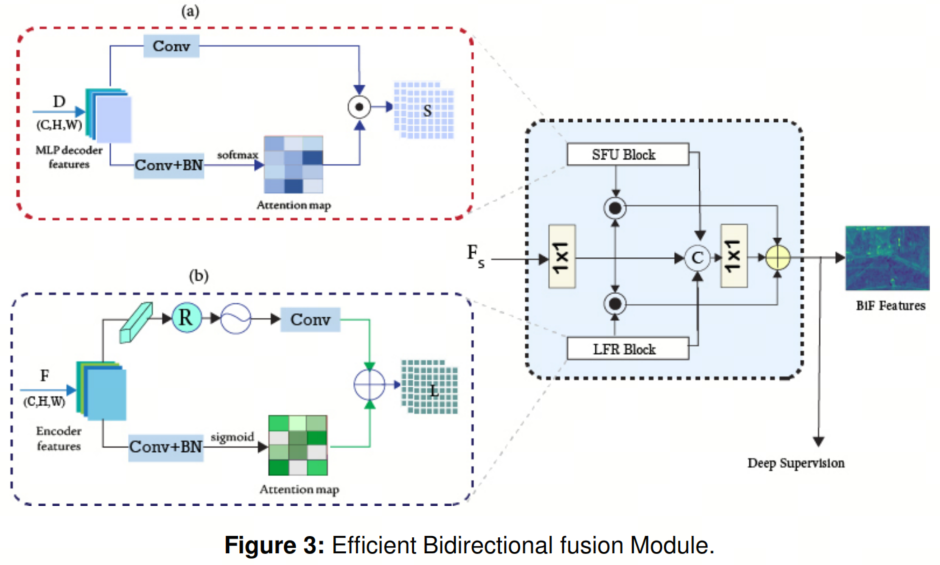

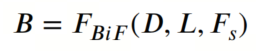

为了高效地合并来自低级编码器和解码模块高语义特征的编码特征表示,作者提出了一个新的双向融合模块(图3),该模块整合了通道注意,用于通过局部特征细化块转换低级特征,语义特征注入和多阶段多级融合机制。在方程3中, 是多级融合函数。

其中 D 是语义描述符,L 表示详细的对象特征, 是阶段特征。

语义特征上采样器(SFU)块:

SFU 用于收集语义特征,如图3.(a)所示。 表示解码器的层 和 的输出。特征金字塔网络是一种将语义特征传播到较低层的丰富细节特征的简单架构。通过将语义特征与多尺度特征融合,目标检测和语义分割的性能显着提高。

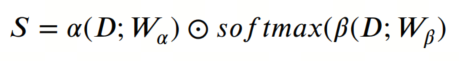

然而,在各个阶段降低通道数的过程中会导致重要信息的丢失。本文引入了语义特征上采样器,一种简单而高效的上采样方法,它使用注意机制有选择地将全局特征注入到BiF模块中。作者将语义特征上采样器记为 ,如下所示:

其中使用不同的1×1卷积层(𝛼 和 𝛽)来映射输入 D,⊙ 表示Hadamard乘积。

局部特征细化块

所提出的架构2采用了双向融合设计,以促进信息在培训过程中从不同阶段的流动。为了保持一致的语义特征融合,作者引入了通道注意(图3.b),以收集全局信息。

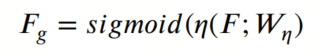

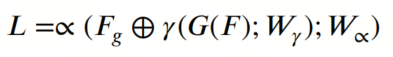

与此同时,还集成了一个空间滤波器,以抑制不相关的信息并增强局部细节,因为低级编码器特征可能会有噪声。局部特征细化块的方程式如下:

其中 𝜂 是具有1×1卷积核的卷积层,

其中(𝛾,∝)代表具有1×1卷积核的卷积,G 表示全局平均池化。

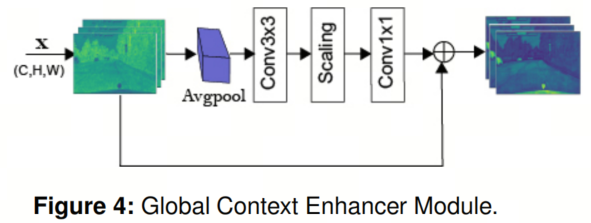

全局上下文增强器(GCE)引入以弥补连接不同语义级别的不足。给定输入特征 ,全局上下文增强器模块首先应用全局平均池化来收集全局语义信息,并使用门控机制选择信息丰富的高语义描述符,有助于去除由编码器的较浅阶段引入的噪音。

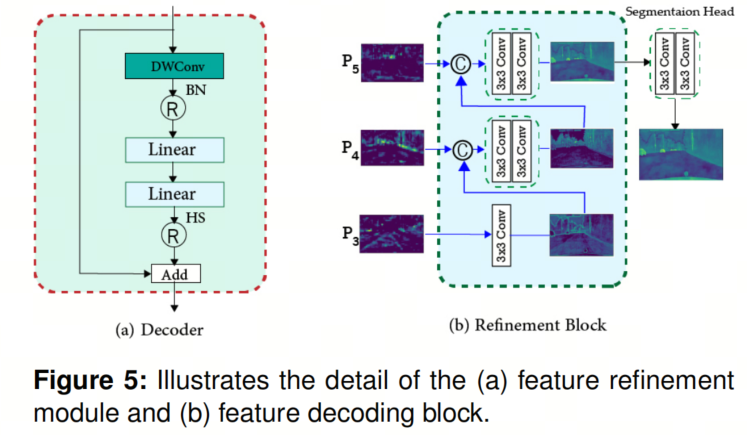

2.4. 特征解码与细化

解码器块(参见图4.(b))由深度卷积组成,kernel-size分别为3、5和7,用于5、4和3阶段,然后进行批量归一化。然后,作者采用两个逐点卷积层来丰富局部表示,并帮助维护对象上下文。

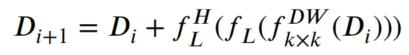

与ConvNeXt不同,后者使用层标准化和高斯误差单元激活,作者使用Hardswish激活进行非线性特征映射。最后,添加了一个跳过连接以促进网络层次结构中的信息流动。此解码器可以表示如下:

其中 是形状为 𝐻 × 𝑊 × 𝐶 的输入特征图, 表示逐点卷积层,后跟Hardswish, 是深度卷积,内核大小为 𝑘 × 𝑘, 表示解码器块的输出特征图。

细化块(图5.b)引入以过滤解码器产生的嘈杂特征,以实现更准确的逐像素分类和定位。

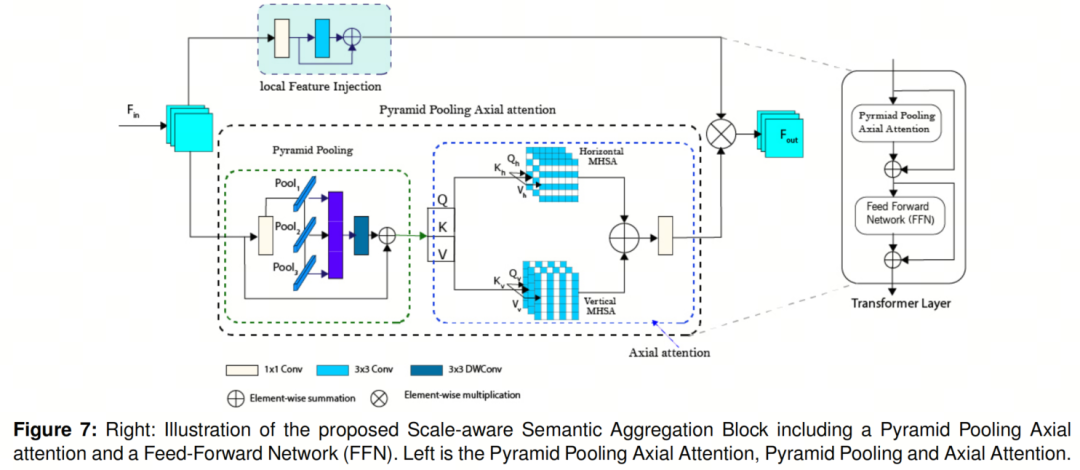

2.5. 尺度感知语义聚合块

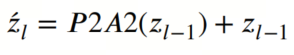

尺度感知语义聚合器由 L 个堆叠的金字塔池化 Axial 注意力块组成。每个Transformer包括金字塔池化 Axial 注意力模块和前馈网络(FFN)。第 个金字塔池化 Axial 注意力块的输出可以表示如下:

其中 、 分别表示输入、Axial 注意力的输出和Transformer块的输出。P2A2 是金字塔池化 Axial 注意力的缩写。

金字塔池化Axial 注意力

在这里,作者介绍了提出的金字塔池化Axial 注意力。主要结构如图7所示。首先,将输入特征馈送到金字塔池化子模块,通过使用不同内核大小执行池化操作来捕获全局上下文信息,见方程12。

接下来,将 Axial 注意力模块应用于池化特征,以捕获垂直和水平 Axial 上的空间依赖关系。该模块利用位置嵌入来编码空间信息,并生成注意力图,突出显示图像中相关区域。然后将注意力图与残差块相结合,以增强空间细节,使模型能够生成信息丰富的上下文信息,从而实现架构在非常小的数据集上获得高精度。

其中 、 、 是生成的金字塔特征。接下来,作者对金字塔特征图进行求和,并在其上执行卷积操作。

Axial 注意力已被引入以减少注意力网络的计算成本。自那以后,它已被集成到许多语义分割框架中。

3. 实验

4. 参考

[1].P2AT: Pyramid Pooling Axial Transformer for Real-time Semantic Segmentation.

点击上方卡片,关注「集智书童」公众号